-

5️⃣ Pytorch 기초_autogradAI\ML\DL/Pytorch 2023. 7. 14. 17:08반응형

1) requires_grad

텐서 객체의 attribute 로, 그래디언트의 계산 여부를 결정한다.

requires_grad 속성을 True 로 설정하여 텐서에 대한 그래디언트 계산을 활성화할 수 있다.

requres_grad 속성이 False 로 설정된 텐서에 대해서는 그래디언트를 계산하지 않는다. 이를 통해 불필요한 계산을 줄여 연산 속도를 향상시킬 수 있다.

2) 역전파 계산

x=torch.tensor([1.], requires_grad=True) y=x**2 y.retain_grad() z=3*y z.backward() print(x.grad) print(y.grad)x -> x**2 -> 3x**2 순으로 진행되므로

x 에 대해서 3x**2 를 chain rule을 통해 편미분하면 결과는 6이 된다.

출력은 다음과 같다.

tensor([6.]) tensor([3.])중간에 있는 y 의 미분 계산은 원래 되지 않는데, y.retain_grad 로 미분값을 유지시켜 주었으므로 볼 수 있다.

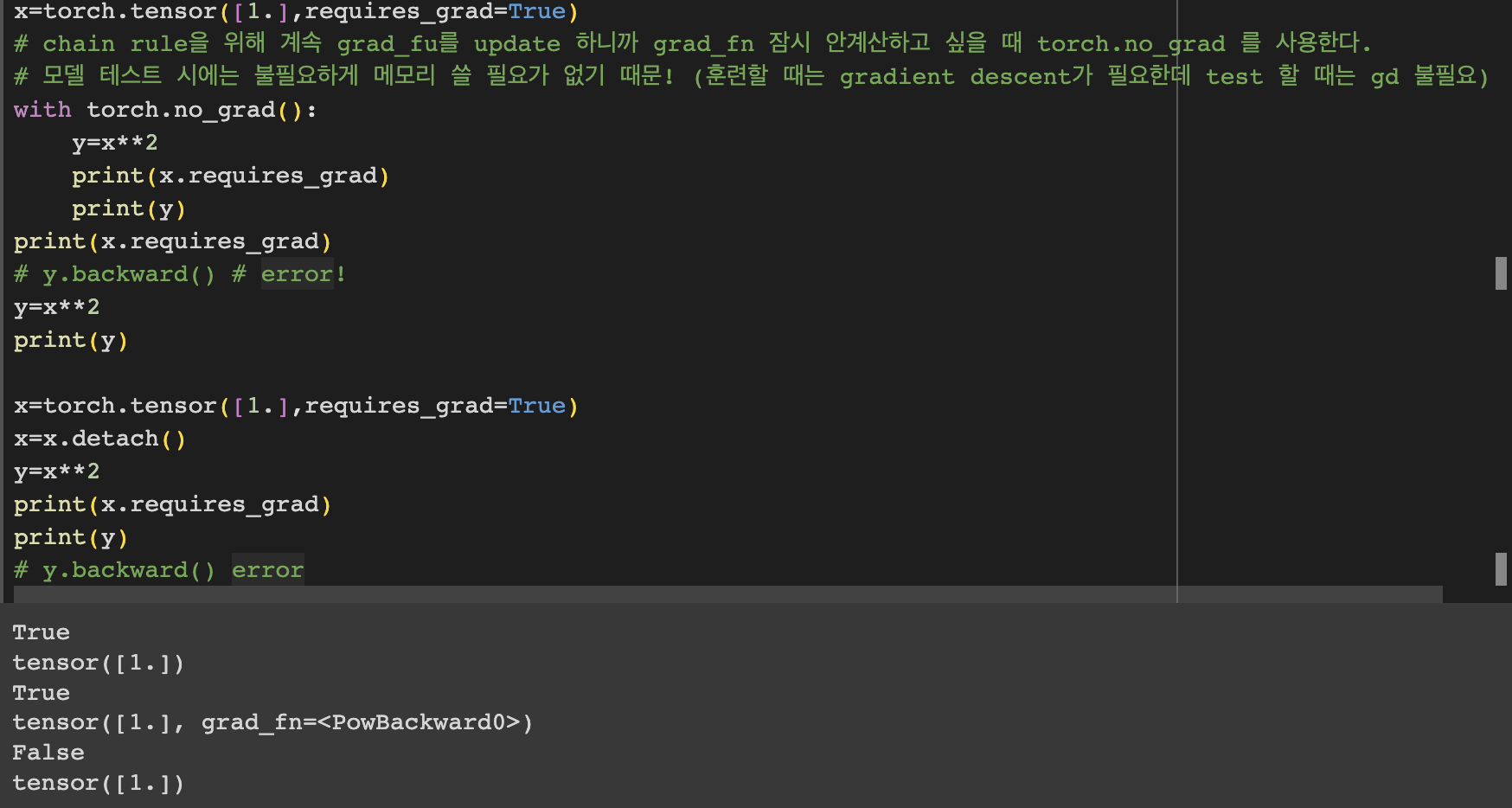

3) detach 와 torch.no_grad

detach() 메서드는 텐서를 그래프 계산에서 분리한다. 즉, 그래디언트 계산을 비활성화하고 해당 텐서를 새로운 텐서로 만든다. 처음에 requires_grad 를 True로 설정했더라도 detach를 해주면 역전파를 수행할 때 오류가 발생한다.

torch.no_grad() 또한 그래디언트 계산을 비활성화해주는 역할을 하며 이를 사용하여 특정 영역을 감싸면 (ex. with) 그 안에서 수행되는 연산은 그래디언트가 계산되지 않는다.

'AI\ML\DL > Pytorch' 카테고리의 다른 글

torch.utils.data.DataLoader (2) 2023.07.25 nn.Linear (1) 2023.07.14 4️⃣ Pytorch 기초_여러 함수들 (0) 2023.07.14 3️⃣ Pytorch 기초_boolean 인덱싱 (0) 2023.07.06